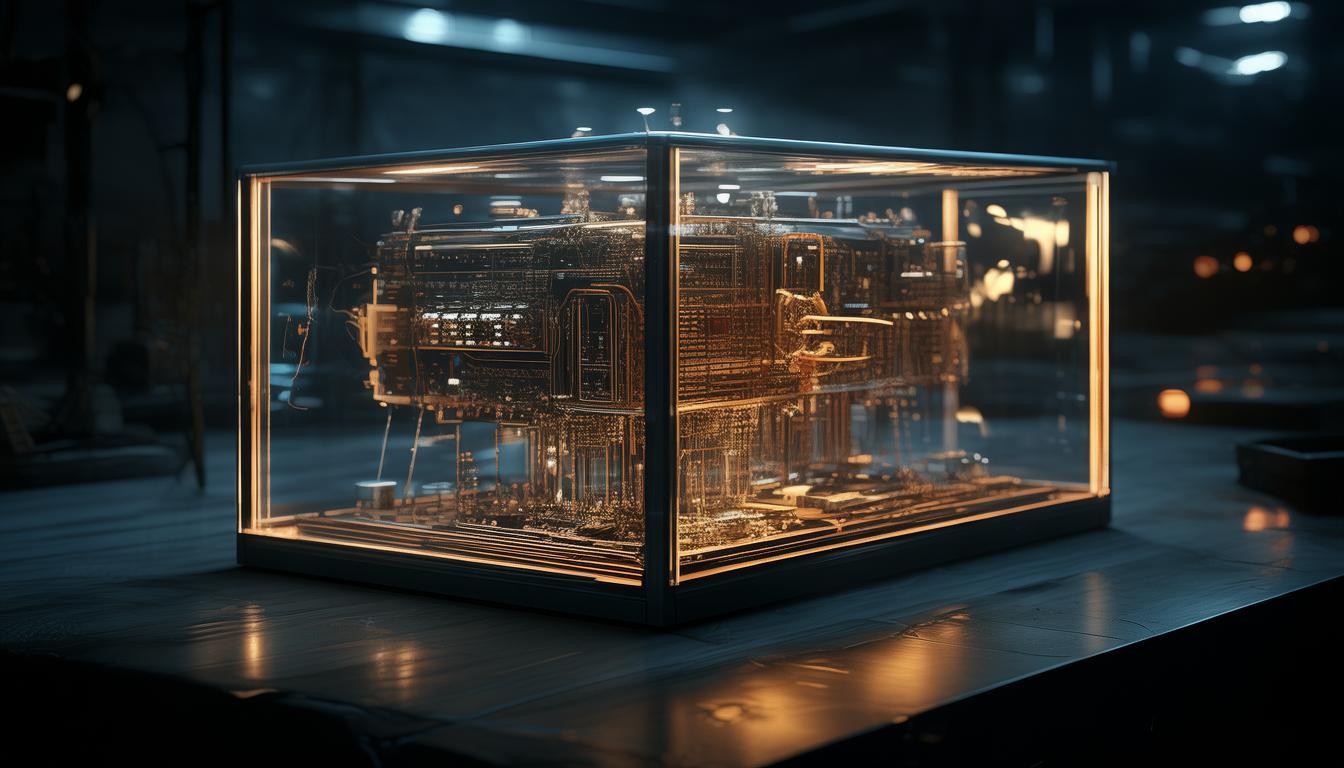

AI模型是黑盒吗?为什么有这样的疑问?

AI模型是否被视为黑盒取决于其透明度和可解释性,有这样的疑问主要是因为许多AI模型,尤其是深度学习模型,内部工作原理复杂,难以直观理解其决策过程,导致用户无法准确知道模型为何做出特定预测或决策,从而引发关于AI模型是否如黑盒般不可知的疑问。

在探讨AI模型是否属于黑盒这一问题时,我们首先需要明确“黑盒”这一概念,在计算机科学和软件工程领域,黑盒通常指的是一种无法从外部直接了解其内部工作原理或结构的系统,对于这样的系统,我们只能通过观察其输入和输出来推断其功能。

让我们将这个概念应用到AI模型上,AI模型,尤其是深度学习模型,通常是通过大量数据进行训练,以学习数据中的模式和关系,这些模型在训练过程中会调整其内部参数,以最小化预测误差或最大化某种性能指标,一旦模型训练完成,其内部参数和决策过程往往对外部用户是不透明的。

这种不透明性导致了关于AI模型是否为黑盒的疑问,从某种程度上说,AI模型确实具有黑盒的特性,用户无法直接查看或理解模型是如何根据输入数据做出决策的,相反,他们只能依赖模型的输出和可能的性能指标来评估其性能。

将AI模型完全视为黑盒也有其局限性,随着解释性AI(Explainable AI, XAI)的发展,研究人员正在开发能够提供更多关于模型决策过程信息的工具和技术,这些技术可以帮助用户更好地理解模型的决策依据,从而增加模型的透明度和可信度。

即使AI模型在某些方面表现为黑盒,我们仍然可以通过其他方式来验证其性能和可靠性,通过交叉验证、独立测试集评估以及与其他模型的比较等方法,我们可以对模型的泛化能力和准确性进行客观评估。

虽然AI模型在某些方面确实具有黑盒的特性,但我们不能简单地将其视为完全的黑盒系统,随着技术的进步和解释性AI的发展,我们有望在未来获得更多关于AI模型内部工作原理的信息,从而进一步提高其透明度和可信度,对于“AI模型是黑盒吗?”这一问题,答案并非绝对,而是取决于我们如何定义和评估模型的透明度以及我们所使用的技术和方法。

上一篇:文心一言API怎么申请? 下一篇:AIGC文心一言测试,真的能达到预期效果吗?

对AI模型是否为黑盒的疑问源于其决策过程不透明,人们渴望了解内在逻辑。